Por que a privacidade dos dados deve ser uma prioridade ao usar a IA em L&D

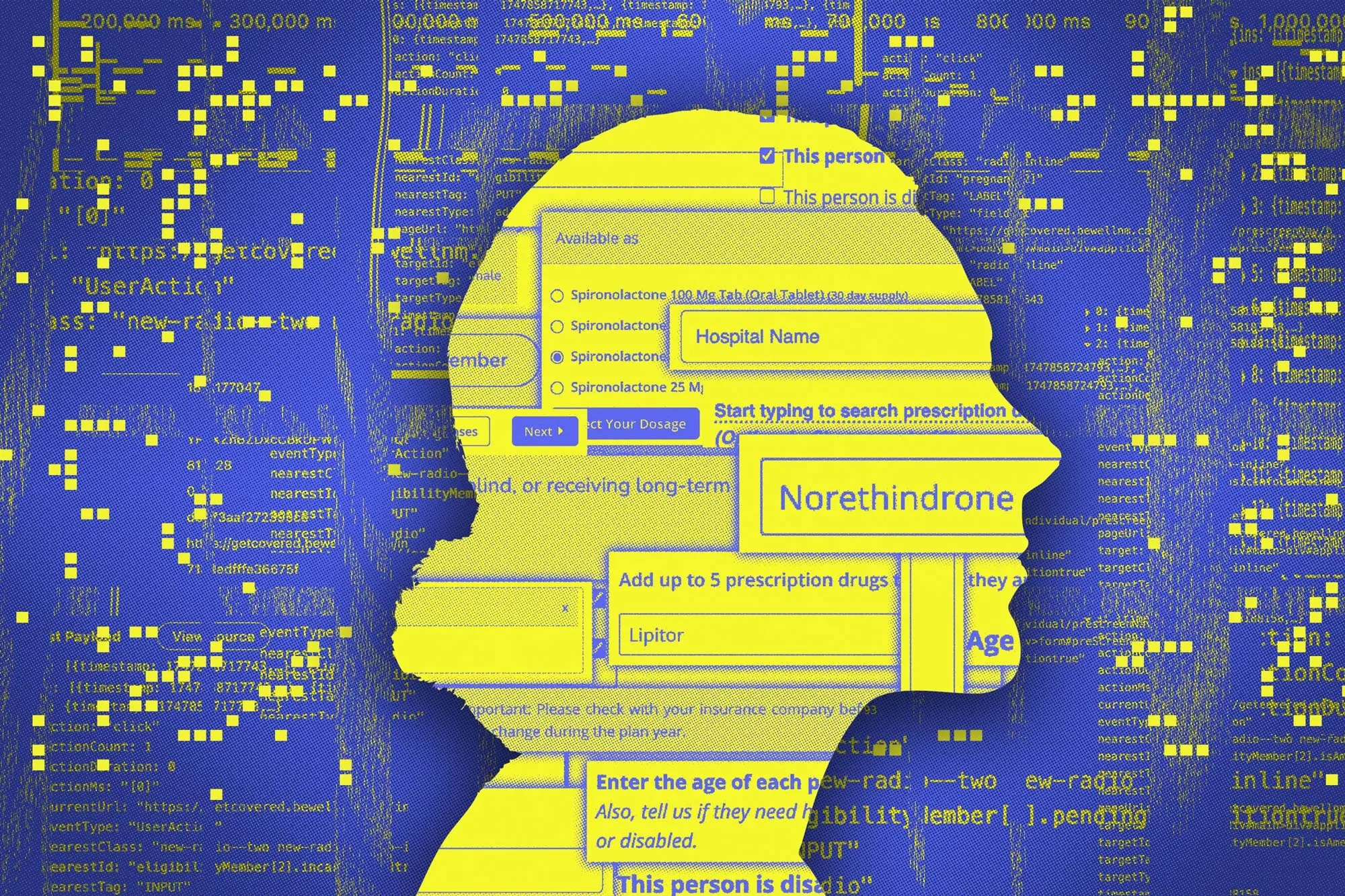

Quando você está usando um LMS movido a IA Para o seu programa de treinamento, você pode notar que a plataforma parece saber exatamente uma vez que você aprende melhor. Ele ajusta a dificuldade com base no seu desempenho, sugere teor que corresponda aos seus interesses e até lembra quando você é mais produtivo. Uma vez que isso faz isso? Ele coleta seus dados. Seus cliques, pontuações, interações e hábitos estão sendo coletados, armazenados e analisados. E é aí que as coisas começam a se tornar desafiadoras. Embora a IA torne o estágio mais inteligente e eficiente, também apresenta novas preocupações: privacidade de dados na IA.

Hoje, as plataformas de estágio hoje podem fazer todos os tipos de coisas para facilitar a vida dos alunos, mas também coletam e processam informações sensíveis ao aluno. E, infelizmente, onde há dados, há riscos. Um dos problemas mais comuns é o aproximação não autorizado, uma vez que violações de dados ou hackers. Depois, há viés algorítmico, onde a IA toma decisões com base em dados defeituosos, que podem afetar injustamente os caminhos ou avaliações de aprendizagem. O excesso de personalização também é um problema, pois a IA sabe muito sobre você pode se sentir uma vez que vigilância. Sem mencionar que, em alguns casos, as plataformas mantêm dados pessoais por muito mais tempo do que o necessário ou sem os usuários, mesmo sabendo.

Neste item, exploraremos todas as estratégias para proteger os dados dos seus alunos e prometer a privacidade ao usar a IA. Por fim, é forçoso para todas as organizações que usam IA em L&D para tornar a privacidade dos dados uma segmento forçoso de sua abordagem.

7 Estratégias principais para proteger a privacidade de dados em plataformas de L&D aprimoradas da AI-

1. Colete unicamente dados necessários

Quando se trata de privacidade de dados em plataformas de estágio movidas a IA, a regra número um é unicamente coletar os dados necessários para estribar a experiência de estágio e zero mais. Isso é chamado de minimização de dados e limitação de propósito. Faz sentido porque todos os dados extras, irrelevantes para o estágio, uma vez que endereços ou histórico de navegador, acrescenta mais responsabilidade. Isso basicamente significa mais vulnerabilidade. Se sua plataforma estiver armazenando dados que você não precisa ou sem um objetivo evidente, você não está unicamente aumentando o risco, mas possivelmente também traindo a crédito do usuário. Portanto, a solução é ser premeditado. Colete unicamente dados que suportam diretamente uma meta de estágio, feedback personalizado ou rastreamento de progresso. Outrossim, não mantenha os dados para sempre. Depois que um curso termina, exclua os dados que você não precisa ou torná -los anônimos.

2. Escolha plataformas com privacidade de dados de IA incorporada

Você já ouviu os termos “privacidade por design” e “privacidade por padrão”? Eles têm a ver com privacidade de dados em plataformas de estágio movidas a IA. Basicamente, em vez de unicamente somar recursos de segurança depois de instalar uma plataforma, é melhor incluir privacidade desde o início. É disso que trata a privacidade do design. Isso torna a segurança dos dados uma segmento forçoso do seu LMS movido a IA em seu estágio de desenvolvimento. Outrossim, a privacidade, por padrão, significa que a plataforma deve manter maquinalmente os dados pessoais seguros sem exigir que os usuários ativem essas configurações. Isso exige que sua forma de tecnologia seja criada para criptografar, proteger e gerenciar dados com responsabilidade desde o início. Portanto, mesmo se você não produzir essas plataformas do zero, investir em software projetado com elas em mente.

3. Seja transparente e mantenha os alunos informados

Quando se trata de privacidade de dados no estágio movido a IA, a transparência é uma obrigação. Os alunos merecem saber exatamente quais dados estão sendo coletados, por que estão sendo usados e uma vez que ele apoiará sua jornada de estágio. Por fim, existem leis para isso. Por exemplo, o GDPR exige que as organizações sejam iniciais e fiquem claras e informadas antes de coletar dados pessoais. No entanto, ser transparente também mostra aos alunos que você os valoriza e que não está escondendo zero. Na prática, você deseja tornar seus avisos de privacidade simples e amigáveis. Use linguagem simples uma vez que “Usamos os resultados do seu teste para apropriar seu experiência de estágio. “Portanto, permita que os alunos escolham. Isso significa oferecer oportunidades visíveis para optar por não optar por não querer.

4. Use possante criptografia de dados e armazenamento seguro

A criptografia é sua medida de privacidade de dados, principalmente ao usar a IA. Mas uma vez que funciona? Ele transforma dados confidenciais em um código ilegível, a menos que você tenha a chave certa para desbloqueá -los. Isso se aplica a dados e dados armazenados em trânsito (informações trocadas entre servidores, usuários ou aplicativos). Ambos precisam de proteção séria, idealmente com métodos de criptografia de ponta a ponta, uma vez que TLS ou AES. Mas a criptografia por conta própria não é suficiente. Você também precisa armazenar dados em servidores seguros e controlados por aproximação. E se você estiver usando plataformas baseadas em nuvem, escolha fornecedores conhecidos que atendam aos padrões de segurança global uma vez que a AWS com as certificações SoC 2 ou ISO. Outrossim, não se esqueça de verificar regularmente seus sistemas de armazenamento de dados para conquistar vulnerabilidades antes de se transformarem em problemas reais.

5. Pratique anonimato

A IA é ótima em produzir experiências personalizadas de estágio. Mas, para fazer isso, ele precisa de dados e informações especificamente sensíveis, uma vez que comportamento do aluno, desempenho, metas e até quanto tempo alguém gasta em um vídeo. Portanto, uma vez que você pode aproveitar tudo isso sem comprometer a privacidade de alguém? Com anonimato e pseudonimização. O anonimato inclui a remoção de nome, email e qualquer identificador pessoal de um aluno completamente antes que os dados sejam processados. Dessa forma, ninguém sabe a quem pertence, e sua utensílio de IA ainda pode estudar padrões e fazer recomendações inteligentes sem relacionar os dados a um sujeito. A pseudonimização oferece aos usuários um sobrenome em vez de seu nome e sobrenome verdadeiros. Os dados ainda são utilizáveis para estudo e até mesmo a personalização contínua, mas a identidade real está oculta.

6. Compre LMSs de fornecedores compatíveis

Mesmo que seus próprios processos de privacidade de dados estejam seguros, você pode ter certeza do Lms Você comprou para fazer o mesmo? Portanto, ao procurar uma plataforma para oferecer aos seus alunos, você precisa ter certeza de que eles estão tratando a privacidade. Primeiro, verifique suas políticas de manuseio de dados. Os fornecedores respeitáveis são transparentes sobre uma vez que coletam, armazenam e usam dados pessoais. Procure certificações de privacidade uma vez que ISO 27001 ou SOC 2, que geralmente mostram que eles seguem os padrões globais de segurança de dados. Em seguida, não se esqueça da papelada. Seus contratos devem incluir cláusulas claras sobre privacidade de dados ao usar a IA, suas responsabilidades, protocolos de violação e expectativas de conformidade. E, finalmente, verifique regularmente seus fornecedores para prometer que eles estejam comprometidos com tudo o que você concordou em relação à segurança.

7. Defina controles e permissões de aproximação

Quando se trata de plataformas de estágio movidas a IA, ter um possante controle de aproximação não significa ocultar informações, mas protegê-las de erros ou uso falso. Por fim, nem todo membro da equipe precisa ver tudo, mesmo que tenha boas intenções. Portanto, você deve definir permissões baseadas em funções. Eles ajudam você a definir exatamente quem pode visualizar, editar ou gerenciar dados do aluno com base em sua função, seja um gestor, instrutor ou aluno. Por exemplo, um treinador pode precisar de aproximação aos resultados da avaliação, mas não deve ser capaz de exportar perfis completos do aluno. Outrossim, use autenticação multifatorial (MFA). É uma maneira simples e eficiente de impedir o aproximação não autorizado, mesmo que a senha de alguém seja invadida. Obviamente, não se esqueça de registrar e monitorar para sempre saber quem acessou o quê e quando.

Epílogo

A privacidade dos dados no estágio movido a IA não é unicamente ser comportável, mas mais sobre a construção de crédito. Quando os alunos se sentem seguros, respeitados e no controle de seus dados, é mais provável que permaneçam envolvidos. E quando os alunos confiam em você, seus esforços de L&D têm maior verosimilhança de ter sucesso. Portanto, revise suas ferramentas e plataformas atuais: eles estão realmente protegendo os dados do aluno da maneira que deveriam? Uma auditoria rápida pode ser o primeiro passo em direção a práticas de IA de privacidade de dados mais fortes, portanto, uma melhor experiência de estágio.